- Hier erhalten Sie einen Top-Kreditvergleich

- Durchsuchen Sie 4 große Kreditvergleichsportale und viele Banken

- Nur 1 Abfrage für all deren günstigen Kreditangebote

Kreditvergleich

- + Tarifcheck ist das Vermittlungsportal von CHECK24

- + Bester Kreditvermittler & Testsieger laut Bankingcheck

- + Auszahlung in 1 bis 2 Tagen

- + Smava bietet eine Günstiger-Geht-Nicht Garantie laut eigener Aussage

- + Konkreter Zinssatz nach Eingabe persönlicher Daten

- + Konkreter Zinssatz nach Eingabe persönlicher Daten

- + Verivox bietet den besten 2/3 Zins

- + Schnelle Zusage und Auszahlung

- Verivox

- Finanzcheck

- Tarifcheck (CHECK24)

- Smava

- Niedrigster 2/3 Zins zuerst

- Bonitätsunabhängige Zinsen

Nächste Schritte

Sobald Sie ein gutes und günstiges Kreditangebot berechnet und gefunden haben, sind das die nächsten Schritte:

- Klicken Sie nach dem Kreditvergleich auf den Button „weitere Informationen“ und Sie werden direkt zum Vergleichsportal oder zur Bank geleitet.

- Beantworten Sie die Fragen im Online-Formular des Kreditanbieters vollständig.

- Übermitteln Sie alle geforderten Unterlagen.

- Identifizieren Sie sich per Post- oder noch schneller mit Video-Ident.

- Der Kredit wird Ihnen nach erfolgreicher Prüfung sofort überwiesen.

Hinweis: Ihr endgültiger Zinssatz wird individuell nach Ihrer Bonität berechnet und kann sich daher nach dem Kreditvergleich ändern.

Teilnehmende Kreditvergleichsportale

Teilnehmende Kreditbanken

| 1822direkt | ABK Bank |

| Auxmoney | Bank of Scotland |

| Barclaycard | Carcredit |

| Cashper | Commerzbank |

| Consorsbank | Consorsfinanz |

| Creditplus | Degussa Bank |

| DKB | Deutsche Bank |

| Dr. Klein | DSL Bank |

| Ferratum | Fidor Bank |

| Giromatch | Hypovereinsbank |

| Ikano Bank | ING |

| Kredit2Day | N26 |

| Norisbank | Novum Bank |

| Oyak Anker Bank | Ofina |

| Postbank | PSD Bank |

| Qlick | Sparkasse Kredit-per-Klick |

| Santander | |

| SKG Bank | SWK Bank |

| Targobank | Vexcash |

| Younited Credit | Kredite24 |

„Sonderzinsen“ der Kreditvergleichsportale“

Jedes Kreditvergleichsportal vermittelt und vermarktet in Kooperation mit einer Kreditbank ihr eigenes Kreditlabel mit eigenen Sonderzinsen.

Diese „Sonderzinsen“ bzw. „Exklusivzinsen“ unterscheiden sich hinsichtlich des maximalen effektiven Jahreszinses und des 2/3 Zinses.

Verknüpft sind diese Kreditangebote mit einigen Voraussetzungen. Zum Beispiel eine sehr gute Bonität oder digitaler Einblick in die Kontosauszüge.

In der Tabelle haben wir die Informationen veröffentlicht (sortiert nach 2/3 Zins):

| Vergleichsportal | Produkt | 2/3 Zins | Effektiver Jahreszins |

|---|---|---|---|

| Finanzcheck | Ofina Kredit | 4,24% | 0,68% bis 13,62% |

| Smava | Kredit2Day | 4,71% | 0,68% bis 5,49% |

| Tarifcheck* | Kredite24 Sofort | 5,49% | 0,68% bis 5,99% |

| Verivox | Turbokredit | 6,49% | 0,68% bis 10,24% |

Quelle: Eigene Recherche. Stand 15.04.2021.

Fazit: Orientieren Sie sich nicht unbedingt an den Sonderzinsen, da diese diversen Bedingungen unterliegen und allem Anschein nach nur schwer zu bekommen sind (Differenz 0,68% zum 2/3 Zins!)

Studie Kreditvergleichsportale Test 2020

Gegenüberstellung verschiedener Kreditvergleichsportale in Bezug auf „Ratenkredite“

Gesamtergebnis:

| Gesamtnote | 1,2 | 1,5 | 2,6 | 2,8 |

| Konditionen | 1,3 | 1,8 | 2,6 | 2,3 |

| Benutzerfreundlichkeit | 1,0 | 1,0 | 3,3 | 3,6 |

| Suche | 1,0 | 1,3 | 4,0 | 4,0 |

| Auswahl der Banken | 1,0 | 1,0 | 2,3 | 2,5 |

| Kundenservice | 2,0 | 1,0 | 2,5 | 2,5 |

| Schufa | 1,0 | 2,0 | 1,0 | 2,0 |

| Anzahl der Treffer | 1,0 | 2,0 | 1,0 | 2,3 |

Kreditvergleiche anderer Websites

Wir haben recherchiert: Nachfolgend finden Sie eine Liste von Websites, die ebenfalls Kreditvergleiche online anbieten.

Wir konnten feststellen, dass alle die Kreditrechner der Vergleichsportale Check24 (direkt zum Check24 Kredit), Verivox, Smava und Finanzcheck einbinden bzw. nutzen.

| Website von | Kreditrechner | |

|---|---|---|

| Check24 | Eigener | weiter |

| Verivox | Eigener | weiter |

| Finanzcheck | Eigener | weiter |

| Smava | Eigener | weiter |

| Tarifcheck | von Check24 | |

| Finanztip | von Verivox | |

| Financescout | von Finanzcheck | |

| Stern | von Finanzcheck | |

| Vergleich.de | von Finanzcheck |

Wieviel Kredit kann ich mir leisten?

Die Arbeitsgemeinschaft Finanzen stellt Ihnen hierzu einen Budgetrechner zur Verfügung, mit welchem Sie ermitteln können, wie hoch Ihr Kredit ausfallen darf, ohne dass die monatlichen Raten Ihren finanziellen Rahmen sprengen.

Dabei stellen Sie Ihre monatlichen Einnahmen Ihren monatlichen Ausgaben gegenüber. Die Differenz ist der Betrag, den Sie am Ende des Monats noch zur Verfügung haben. Dieser kann dann zur Tilgung der Kreditraten genutzt werden.

Bei den Lebenshaltungskosten können Sie diese Pauschalen angeben:

- 650 € für den Kreditnehmer

- 250 € für jede weitere im Haushalt lebende Person

Praxis-Tipp: Lassen Sie sich etwas finanziellen Spielraum! Planen Sie nicht den gesamten Differenzbetrag für die Kredittilgung ein.

Wichtige Fragen – kurz beantwortet

- Sind Sondertilgungen kostenlos möglich?

- Sind Ratenpausen möglich?

- Wird mir keine sinnlose Restschuldversicherung angeboten?

Eine umfassende Recherche und Kreditvergleich ist zu empfehlen, bei Direktbanken online und auch bei Ihren Banken vor Ort. Lassen Sie sich verschiedene Angebote unterbreiten und scheuen Sie sich nicht vor Zinsverhandlungen.

In unserem Kredit-Ratgeber

- Was muss ich vor der Kreditaufnahme beachten?

- So funktioniert der Kreditvergleich

- Verwendungszwecke bei Krediten

- Welche Voraussetzungen brauche ich für einen Kredit?

- Unterlagen für die Kreditaufnahme

- Was muss ich zu Onlinekrediten wissen?

Was muss ich vor der Kreditaufnahme beachten?

Können Sie gewährleisten, monatlich über einen längeren Zeitraum einen bestimmten Betrag X als Tilgungsrate aufzubringen, dann kann ein klassischer Konsumentenkredit genau das Richtige für Sie sein.

Doch nicht jeder Kredit, der in monatlichen Raten zurückgezahlt wird, ist mit denselben Merkmalen und Konditionen ausgestattet.

Ein Rahmenkredit beispielsweise eignet sich hervorragend, wenn Sie immer einmal wieder bestimmte Beträge schnell abrufen müssen, ein Ratenkredit, wenn Sie eine größere Summe auf einmal benötigen.

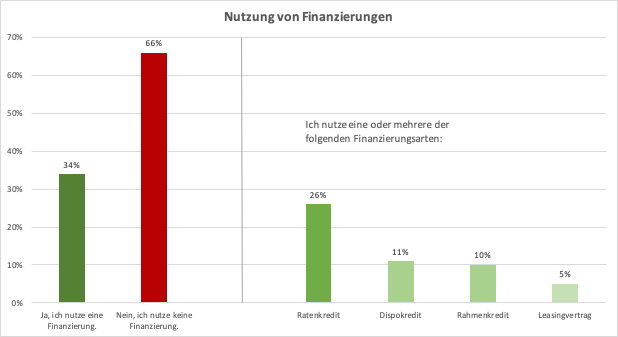

Der Ratenkredit bleibt allerdings nach wie vor die beliebteste Kreditart, vor dem Dispokredit und dem Rahmenkredit.

Quelle: Eigene Darstellung; Bankenfachverband, 2019, „Marktstudie 2019 – Konsum- und Kfz-Finanzierung“, Seite 5

Wichtiges zu Konditionen und Laufzeit

Heutzutage sind Kreditrechner unverzichtbar für das Vorhaben der Kreditaufnahme geworden. Kreditvergleichsportale vergleichen die Angebote der Kreditinstitute und unsere Kreditsuchmaschine vergleicht die verschiedenen Ergebnislisten der Portale.

Bedenken Sie, dass auch bei Krediten mit demselben Zinssatz unterm Strich ein anderes Ergebnis herauskommen kann, insofern sich die Laufzeiten unterscheiden. Oftmals ändern sich auch die Zinssätze laufzeitabhängig.

Praxis-Tipp: Allgemein gilt – je kürzer die Laufzeit, desto geringer der Zinsaufwand.

Das bedeutet jedoch nicht automatisch, dass eine kürzere Laufzeit immer die bessere Wahl ist. Eine kurze Laufzeit bedeutet auch höhere monatliche Raten. Sollten Sie nicht in der Lage sein, diese regelmäßig zu begleichen, fallen schnell hohe Kosten für den Zahlungsverzug an.

Weiterhin sollten Sie auch nicht nur auf einen günstigen Zinssatz achten. Auch andere Vertragskonditionen können von großer Bedeutung sein, wenn es zum Abschluss eines Kreditvertrages kommt.

Wir von der Arbeitsgemeinschaft Finanzen haben daher eine Liste mit den wichtigsten Konditionen zusammengetragen, die im Vorhinein zu prüfen sind.

- Sind Sondertilgungen bzw. eine Gesamttilgung kostenlos möglich?

- Ist die Umschuldung bzw. Ablösung bereits bestehender Kredite möglich?

- Sind Ratenpausen kostenlos möglich?

- Kann der Kreditvertrag nur innerhalb der gesetzlichen Frist von 14 Tagen widerrufen werden oder auch länger?

- Erhalten Bestands- und Neukunden dieselben Konditionen?

Machen Sie sich Gedanken dazu, welche der aufgeführten Punkte für Sie besonders wichtig sind. Besteht die Möglichkeit auf den Erhalt einer größeren Geldsumme, welche eine Gesamttilgung möglich machen würde? Stellen Sie sicher, dass Vertragsbedingungen, welche für Sie persönlich wichtig sind, im Vertrag enthalten und gegebenenfalls auch kostenlos sind.

Sondertilgungen, Gesamttilgung und Ratenpausen

Gerade Sondertilgungen sollten kostenfrei für Sie möglich sein, um die Kreditsumme, wenn gewünscht, schneller zurück zahlen zu können. Bei einer Gesamttilgung fällt oftmals eine Vorfälligkeitsentschädigung an. Sie müssen also der Bank einen gewissen Betrag zahlen, da die Zinszahlungen durch die vorzeitige Rückzahlung entfallen.

Diese Vorfälligkeitsentschädigung ist allerdings gesetzlich geregelt und darf nicht mehr als 1% der Restschuld betragen. Sollte Ihr Kreditvertrag weniger als 12 Monate Restlaufzeit haben, dann darf die Bank sogar nicht mehr als 0,5% der Restschuld von Ihnen verlangen.

Manche Banken bieten aber auch die Möglichkeit, einen Kredit, teilweise oder gesamt, kostenfrei zu tilgen. Dies kann sich vor allem dann für Sie auszahlen, wenn der Eingang einer größeren Geldsumme, z. B. über ein Erbe, in den nächsten Jahren für Sie in Aussicht steht.

Auch Ratenpausen sollten kostenlos für Sie möglich sein, da es aufgrund unvorhersehbarer Ereignisse immer einmal wieder zu finanziellen Engpässen kommen kann. Damit Sie in einem solchen Fall nicht auch noch vor zusätzlichen Kosten durch Gebühren stehen, lohnt sich ein Kredit, der kostenlose Ratenpausen ermöglicht.

Restschuldversicherung

Eine Restschuldversicherung oder auch Kreditabsicherung übernimmt bei Berufsunfähigkeit oder Tod monatlichen Ratenzahlungen für Ihren Kredit.

Eine solche Versicherung können Sie oft direkt bei der kreditgebenden Bank zusammen mit Ihrem Kredit abschließen. Es gibt allerdings auch die Möglichkeit, die Versicherung über eine dritte Partei abzuschließen.

Eine Restschuldversicherung kann durchaus sinnvoll sein, doch sollten Sie sich den Abschluss genau überlegen. Zusätzlich zur monatlichen Rückzahlung des Kredites, inklusive Zinsen, kommt dann nämlich auch noch der Betrag für die Versicherung.

Je nach Anbieter können die Kosten hier noch einmal beträchtlich sein. Um daher eine zu hohe finanzielle Belastung zu vermeiden, sollten Sie genau abwägen, ob eine Restschuldversicherung für Sie sinnvoll ist und im nächsten Schritt durchrechnen, welche Versicherung Sie sich leisten können.

So funktioniert der Kreditvergleich

Haben Sie die wesentlichen Eckpunkte, d. h. Laufzeit und Nettodarlehensbetrag, passend für Ihren Kredit definiert, können Sie sich z. B. an Ihre Hausbank wenden oder ein anderes Bankhaus vor Ort aufsuchen, um dort den Kredit zum Abschluss zu bringen.

Jedoch stellt diese Variante eine der teuersten Möglichkeiten für den Kreditabschluss dar. Denn wenn Sie sich die Website Ihrer Hausbank einmal genauer ansehen, dann werden Sie schnell feststellen, dass sogar dort derselbe Kredit, nur online abgeschlossen, bereits um einiges günstiger ist.

Das kommt daher, dass die Konkurrenz im Internet wesentlich größer ist und somit auch der Wettbewerb um einiges härter. Anbieter müssen mit günstigeren Angeboten auf sich aufmerksam machen um aus der Menge von Kreditangeboten herauszustechen und genügend Kunden für sich zu gewinnen.

Mit der nächsten Generation an Bankkunden kommt außerdem auch frischer Wind in das alteingesessene Bankwesen. Inzwischen ist es den Kunden lieber, wenn sie selbst Informationen und Daten zu ihrer Person online eingeben, anstatt dies wie früher einem Bankangestellten in der Filiale zu überlassen.

Praxis-Tipp: Vergleichen Sie Kredite online. Durch die größere Konkurrenz können Sie sich günstigere Konditionen sichern.

Die von uns geprüften Kreditvergleichsportale sind hierbei selbst keine Kreditgeber. Sie verfügen allerdings über ein großes Portfolio an Partnerbanken, von dem Sie profitieren können. Denn der Service der Portale ermöglicht es Ihnen sämtliche Anbieter gleichzeitig und sekundenschnell zu überprüfen. So finden Sie sicher das aktuell günstigste Angebot.

Um Kreditangebote auf einem der Portale zu vergleichen, müssen Sie zunächst einige Daten eingeben. So zum Beispiel Ihre gewünschte Kreditsumme, Ihre gewünschte Kreditlaufzeit und Ihren Verwendungszweck.

Im nächsten Schritt haben wir auch diese Vergleichsportale in unseren Kreditvergleichsrechner, die sogenannte Kreditsuchmaschine, integriert. So können Sie in Sekundenschnelle die Angebote der Vergleichsportale und weiterer Banken miteinander vergleichen, ohne ständig zwischen verschiedenen Webseiten hin- und herwechseln zu müssen.

Nach der Eingabe von Kredithöhe und Laufzeit in einen Kreditrechner, bekommen Sie eine Ergebnisliste angezeigt, welche aus den Banken und deren Angeboten besteht.

Viel mehr liefern die Ergebnisse Ihnen einen ersten umfangreicheren Überblick über die Anbieter auf dem aktuellen Markt und geben Ihnen ein Gefühl dafür, wie es um die derzeitigen Zinssätze steht.

Beachten Sie: Es wird ein Großteil der Banken bei Kreditvergleichsportalen aufgeführt, allerdings nicht alle.

Verschiedene Zinsarten

Der gebundene Sollzinssatz (p.a.), früher auch Nominalzins, stellt sozusagen den reinen, von der Bank gebotenen, Zinssatz dar. Er bildet die Basis für den effektiven Jahreszins.

Im effektiven Jahreszins sind wiederum der gebundene Sollzinssatz und alle zusätzlichen Kosten kombiniert. Zusätzliche Kosten können z. B. Bearbeitungsgebühren sein.

Die Resultate der Vergleichsportale zeigen auf den ersten Blick lediglich den Best-Zins des Kreditinstituts in Form des günstigsten effektiven Jahreszinses an. Dass Sie am Ende aber auch diesen niedrigen Zinssatz erhalten, kann in keinem Fall garantiert werden.

Welchen Zinssatz innerhalb der oft weiten Spannen, die angegeben werden, Sie letztendlich erhalten, können Sie nur durch eine Anfrage über das Online-Formular des Anbieters herausfinden.

Ein fundierter Vergleich ist jedoch trotzdem möglich. Achten Sie hierzu auf den sogenannten Zwei-Drittel-Zins. Denn das ist der Zinssatz der für mindestens zwei Drittel aller Kunden dieser Bank zum Einsatz kommt. Der Zwei-Drittel-Zins befindet sich oft im repräsentativen Beispiel des Anbieters, welches gemäß Preisangabenverordnung (PangV) angegeben werden muss.

Was muss ich während des Kreditvergleichs beachten?

Ohne genauere Daten zu Ihrer Person kann leider keiner der Kreditrechner den richtigen Kredit für Sie finden und einen genauen Zinssatz berechnen. Um Ihren Wunschkredit zu finden, müssen Sie daher an den entsprechenden Stellen in die Tiefe gehen. Die folgenden Angaben werden oft nicht gerne gemacht, sind aber für die Berechnung des für Sie optimalen Angebots essentiell:

- Angaben zu Ihrer Person

- Angaben zu Ihrem monatlichen Einkommen

- Angaben zu monatlichen Ausgaben

- Angaben zu Ihren Verbindlichkeiten

- Angaben zu zweiten Kreditnehmern und Bürgen

Der Vorteil bei Vergleichsportalen ist hierbei, dass die Eingabe dieser Angaben nur einmal fällig wird, da die Daten dann im nächsten Schritt an die Partnerbanken weitergeleitet werden. An dieser Stelle wird Ihnen durch das Portal auch ein Berater zur Seite gestellt, der bei jeglichen Fragen und Bedenken Ihrerseits für Sie da ist.

Verwendungszwecke bei Krediten

Warum Sie einen Kredit nicht „einfach so“ aufnehmen sollten

Ein Kredit sollte nur dann aufgenommen werden, wenn dieser auch notwendig ist. Benötigen Sie das Geld nicht dringend, dann sollte kein Kredit aufgenommen werden. Können Sie das benötigte Geld z.B. durch anderweitige Ersparnisse aufbringen, dann sollten Sie dies auch in Erwägung ziehen. Denn aufgrund der Zinszahlungen zahlen Sie am Ende bei einem Kredit immer drauf.

Diese zusätzlichen Zahlungen müssen Sie, wie bereits weiter oben im Text erwähnt, vor der Kreditaufnahme gut durchkalkulieren. Sie müssen sich sicher sein, dass Sie die monatlichen Raten über die gesamte Laufzeit hinweg decken können, ohne sich damit in die Schuldenfalle zu stürzen.

Es gibt jedoch viele Gründe, welche für die Aufnahme eines Kredites sprechen. Oft reichen schon kleinere Kreditsummen aus um Ihnen bei der Verwirklichung Ihrer Träume oder der Anschaffung essentieller Güter zu helfen.

Verschiedene Verwendungszwecke bei Krediten

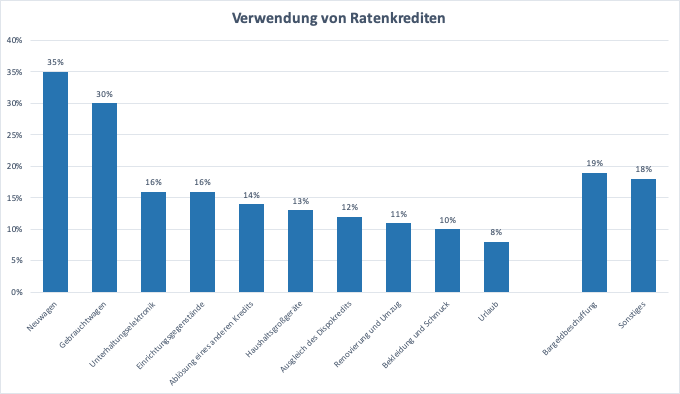

Die möglichen Verwendungszwecke von Krediten sind so unterschiedlich wie die Kreditsummen selbst. Vom Möbelkauf über die Deckung von Renovierungskosten bis hin zur komplett freien Verwendung des Geldes ist vieles möglich.

Kleinere Kredite werden dabei häufig für die Finanzierung von Urlauben, Möbeln und großen Familienfeiern verwendet. Je höher die Kreditsumme wird, desto größer werden dementsprechend auch die Anschaffungen. Autos, Renovierungsarbeiten und ganze Häuser werden hier über das geliehene Geld finanziert.

Quelle: Eigene Darstellung; Bankenfachverband, 2019, „Marktstudie 2019 – Konsum- und Kfz-Finanzierung“, Seite 9

Ein weiterer beliebter Grund für die Kreditaufnahme ist die Kreditumschuldung oder auch Kreditablösung. Hier zahlen Sie mit dem Geld, das Sie über den neuen Kredit erhalten, alte Kredite zurück. Sie sparen sich aufgrund der oftmals viel niedrigeren Zinsen des neuen Kredites bares Geld.

Sollten Sie mehrere Kredite ablösen, so erhalten Sie auch einen besseren Überblick über Ihre Zahlungen. Denn anstatt viele einzelne Kredite abzubezahlen, haben Sie nun nur noch eine monatliche Rate zu tilgen.

Praxis-Tipp: Prüfen Sie zuvor, ob die Umschuldung als Verwendungszweck bei der Bank Ihrer Wahl zulässig ist. Manche Kreditinstitute schließen diese nämlich aus.

Bei vielen Kreditinstituten ist es auch möglich einen Kredit zur freien Verwendung zu erhalten. In diesem Fall können Sie das Geld verwenden wofür Sie wollen. Ob Sie dann letztendlich ein Auto kaufen oder bestehende Kredite ablösen, bleibt ganz Ihnen überlassen.

Zweckbindung bei Krediten

Sie wissen bereits ganz genau, was Sie mit dem geliehenen Geld machen wollen? Dann sollten Sie dies bei der Bank auch angeben. Denn eine Zweckbindung kann Ihnen im besten Fall günstigere Konditionen und niedrigere Zinssätze verschaffen.

Ein klassisches Beispiel ist die Aufnahme eines Kredites zur Finanzierung eines Autos. Hierbei reichen Sie den Fahrzeugbrief des Wagens bei der Bank ein und sorgen so für zusätzliche Sicherheit. Im Gegenzug werden Ihnen von Banken dann oft günstigere Zinsen gewährt. Genauso verhält es sich mit einem Haus als Sicherheit für einen Baukredit.

Welche Voraussetzungen brauche ich für einen Kredit?

Für einen Kredit sind in der Regel diese Voraussetzungen notwendig:

- Volljährigkeit

- Ständiger Wohnsitz in Deutschland

- Girokonto bei einer Bank in Deutschland

- Geregeltes Einkommen

- Mindestens ausreichende Bonität

Bonität und der Schufa-Score

Die Schufa ist bei jedem Kredit ein ganz empfindliches Thema. Ein schlechter Schufa-Score trägt nämlich sehr oft dazu bei, dass es zur Ablehnung eines Antrages kommt. Zudem ist die Schufa bzw. der Score maßgeblich daran beteiligt, wie am Ende die Konditionen für Ihren Kredit ausfallen.

Sobald eine Bank in Deutschland einen Antrag auf einen Kredit erhält, leitet sie als einen der ersten Schritte die Abfrage der Schufa in die Wege. Über diese Auskunft macht sich das Kreditinstitut ein erstes Bild über die Bonität und Zahlungswürdigkeit des interessierten Kreditnehmers.

Praxis-Tipp: Achten Sie darauf, dass eine neutrale Schufa-Anfrage durch das Kreditinstitut gestellt wird. Durch diese wird Ihr Schufa-Score nicht belastet.

Aber keine Sorge! Alle Vergleichsportale, welche wir von der Arbeitsgemeinschaft Finanzen empfehlen, arbeiten ausschließlich mit Banken zusammen, die neutrale Anfragen an die Schufa stellen.

Alternative Privatkredit

Negative Einträge in der Schufa erschweren die Aufnahme eines Kredits oder verteuern die angebotenen Zinsen. Bei bestehender größerer Verschuldung können Sie auf einen Privatkredit ausweichen. Hier wird Ihnen nicht von einem Kreditinstitut Geld geliehen, sondern von Investoren, welche Sie über Vermittlungsseiten, wie z.B. Auxmoney, finden. Da kein deutsches Kreditinstitut involviert ist, sind Schufa-Auflagen wesentlich lockerer. Seien Sie hier jedoch auch vorsichtig, da die Konditionen hoch ausfallen können. Suchen Sie gegebenenfalls eine Schuldnerberatung auf, um nicht in die Schuldenfalle zu tappen.

Alternative Policendarlehen

Eine weitere Alternative kann ein Policendarlehen sein. Dadurch beleihen Sie Ihre Lebensversicherung bis maximal zur Höhe des Rückkaufswertes. Der Vorteil ist, dass dies nicht in der Schufa eingetragen wird, sich demnach Ihr Schufa-Score nicht verschlechtert.

Kredite für Selbstständige

Sollten Sie Ihr Einkommen aus selbständiger oder freiberuflicher Arbeit beziehen, dann ist die Kreditaufnahme leider nicht immer ganz so einfach wie für Antragsteller mit festem Arbeitsverhältnis.

Das Zahlungsausfallrisiko wird von Banken bei Selbstständigkeit als höher beurteilt, da hier kein geregeltes monatliches Einkommen von einem Arbeitgeber bezogen wird. Eine Kreditaufnahme ist aber trotz allem nicht unmöglich.

Einige Banken gewähren Kredite für Selbstständige nach detailliertem Nachweis der Bonität, z. B. über Einkommensnachweise und Einkommensüberschussrechnungen. Anderen Banken genügt es, wenn Sie nachweisen können, dass Sie seit mindestens zwei Jahren Ihre regelmäßigen Einnahmen aus selbstständiger Arbeit beziehen.

Geben Sie daher nicht auf und suchen Sie gezielt nach Kreditangeboten für Selbstständige.

Unterlagen für die Kreditaufnahme

Dokumente und Nachweise

Unterschiedliche Personengruppen benötigen unterschiedliche Dokumente für die Kreditaufnahme. Im vorherigen Absatz haben wir bereits über Dokumente gesprochen, welche Selbstständige für die Aufnahme eines Kredites benötigen. Bei Personen mit normalem Arbeitsverhältnis genügen allerdings oft die folgenden Unterlagen:

- Eine Kopie des Personalausweises oder Reisepasses

- Die Einkommensnachweise der letzten zwei bis fünf Monate

Manche Banken fordern allerdings noch weitere Dokumente, wie z.B. ungeschwärzte Kontoauszüge. Weiterhin muss sich auch jeder Neukunde einem Identifikationsverfahren unterziehen um seine Identität zu beweisen. Hierzu wird der Personalausweis oder Reisepass benötigt. Wie diese Verfahren ablaufen erklären wir Ihnen im nächsten Absatz.

Post- und Video-Ident-Verfahren

Das klassische und bewährte Post-Ident-Verfahren zur Legitimation der Kreditnehmer wird nach und nach durch das papierlose Video-Ident abgelöst. Damit sind Sie nicht mehr von Öffnungszeiten der Post- oder Bankfilialen abhängig. Schlange stehen, um in der Filiale Ihren Ausweis vorzuzeigen, kann damit endlich der Vergangenheit angehören.

Online lässt sich die Legitimation durch die Videotelefonie bereits in wenigen Minuten schnell und bequem von zu Hause oder unterwegs bewältigen. Das Einzige, was Sie dazu benötigen, ist ein mit dem Internet verbundenes Endgerät (Smartphone, Tablet, Notebook, PC) mit Mikrofon und Webcam, sowie Ihren Personalausweis oder Reisepass.

Vom Kreditinstitut oder vom Kundenberater eines Kreditvergleichsportals erhalten Sie die Information, ob Ihre ausgesuchte Bank dieses neue Legitimationsverfahren anbietet.

Der Ablauf eines Video-Ident-Verfahrens

An Ihre E-Mail erhalten Sie einen Link, mit dem Sie mit einem Mitarbeiter des durchführenden Legitimationsdienstes per Video verbunden werden. Dieser hat nur die Identitätsprüfung durchzuführen, er ist nicht im Besitz von Informationen über Ihren gestellten Kreditantrag oder sonstigen persönliche Angaben.

Der ganze Prozess dauert weniger als fünf Minuten. Der Mitarbeiter fotografiert mithilfe der Webcam Ihr Legitimationspapier und stellt durch visuelle Sicherheitselemente die Echtheit und die Übereinstimmung mit Ihrer Person fest. Zuletzt übernimmt er schriftlich die Angaben Ihres Ausweises, die Sie durch Eingabe einer TAN bestätigen. Die TAN erhalten Sie dabei auf Ihr Smartphone.

Was muss ich zu Onlinekrediten wissen?

Direkt- vs. Filialbanken

Ihre Hausbank um die Ecke ist natürlich auch bei der Kreditaufnahme ein guter Ansprechpartner. Hier erhalten Sie persönlichen Service vor Ort. Langjährige Kunden können sich zudem oft über gute Angebote freuen.

Sie sollten jedoch in jedem Fall auch einen online Kreditvergleich vornehmen. Denn oftmals ist das Kreditangebot Ihrer Hausbank im Internet günstiger als die vor Ort angebotenen Konditionen. Das liegt an der großen Auswahl an Kreditanbietern im Internet und dem damit verbundenen härteren Wettbewerb. Die vielen Banken und Vermittler müssen günstige Zinsen und Konditionen anbieten, um Kunden für sich zu gewinnen.

Direktbanken sind dabei meist noch günstiger, als Anbieter, welche auch Filialen betreiben. Denn durch den Wegfall eben dieser Filialen, sparen sich die Direktbanken viele Ausgaben und können dieses Ersparnis über günstige Zinssätze an ihre Kunden weitergeben.

Praxis-Tipp: Führen Sie auf jeden Fall einen online Kreditvergleich durch, es locken günstigere Konditionen und sogar Angebote, welche exklusiv nur online vergeben werden.

Vergleichen Sie Angebote von Direkt- und Filialbanken und entscheiden Sie, welche Punkte für Sie besonders wichtig sind. Legen Sie großen Wert auf ein persönliches Verkaufsgespräch vor Ort, sollten Sie sich für das Angebot einer Filialbank entscheiden. Möchten Sie Ihre Angaben online selbst eingeben und telefonisch oder per E-Mail beraten werden, so können Sie sich guten Gewissens für einen Onlinekredit bei einer Direktbank entscheiden.

Kreditvermittler

Beim Vergleich von Kreditangeboten werden Sie unvermeidlich auch auf Kreditvermittler stoßen. Hierbei handelt es sich um Unternehmen, welche über ihre Webseite Kredite von Banken anbieten. Die Art der Kredite und die Partnerbanken können dabei sehr variieren.

Manch ein Kreditvermittler hat lediglich kleinere, deutsche Banken im Portfolio und vermittelt deren Kredite eventuell sogar exklusiv. Andere Kreditvermittlungsunternehmen bauen vor allem auch auf Beziehungen zu Banken im Ausland um ihre Services zu erweitern.

Lesen Sie sich die Konditionen des Kreditvermittlungsunternehmens genau durch. Welche Bank steckt zum Schluss wirklich hinter Ihrem Kredit? Fallen Gebühren für die Vermittlung an? Welche Konditionen werden angeboten?

In jedem Fall sollten Sie die Kreditangebote der Vermittler bei Ihrem Vergleich miteinbeziehen und prüfen, denn hier können noch einmal andere Konditionen auf Sie warten, welche Sie bei klassischen Banken vergeblich suchen.

Unseriöse Kreditangebote

Mit vielen verschiedenen Angeboten kommen auch immer wieder unseriöse Kreditangebote auf. Hier müssen Sie sich in Acht nehmen! Lassen Sie sich z. B. auf keinen Fall auf einen Termin bei sich zu Hause ein. Seriöse Anbieter haben entweder ein Büro oder eine Filiale, in der Sie sich treffen können oder regeln die Beratung komplett auf telefonischem Wege bzw. über E-Mail-Kontakt.

Wir empfehlen für den Kreditvergleich die Portale Verivox, Smava und Finanzcheck. Sie haben sich über die Jahre bewährt und haben auch nach unserem Kreditportalvergleich im Jahre 2020 hervorragend abgeschnitten. Von seriösen Angeboten können Sie bei diesen Portalen ausgehen.

Um die verschiedenen Portale auch untereinander vergleichen zu können, empfehlen wir unsere Kreditsuchmaschine. Diese vergleicht die Angebote der Vergleichsportale sowie jene von weiteren seriösen Banken. So sparen Sie wertvolle Zeit und der Kreditvergleich ist einfacher denn je.